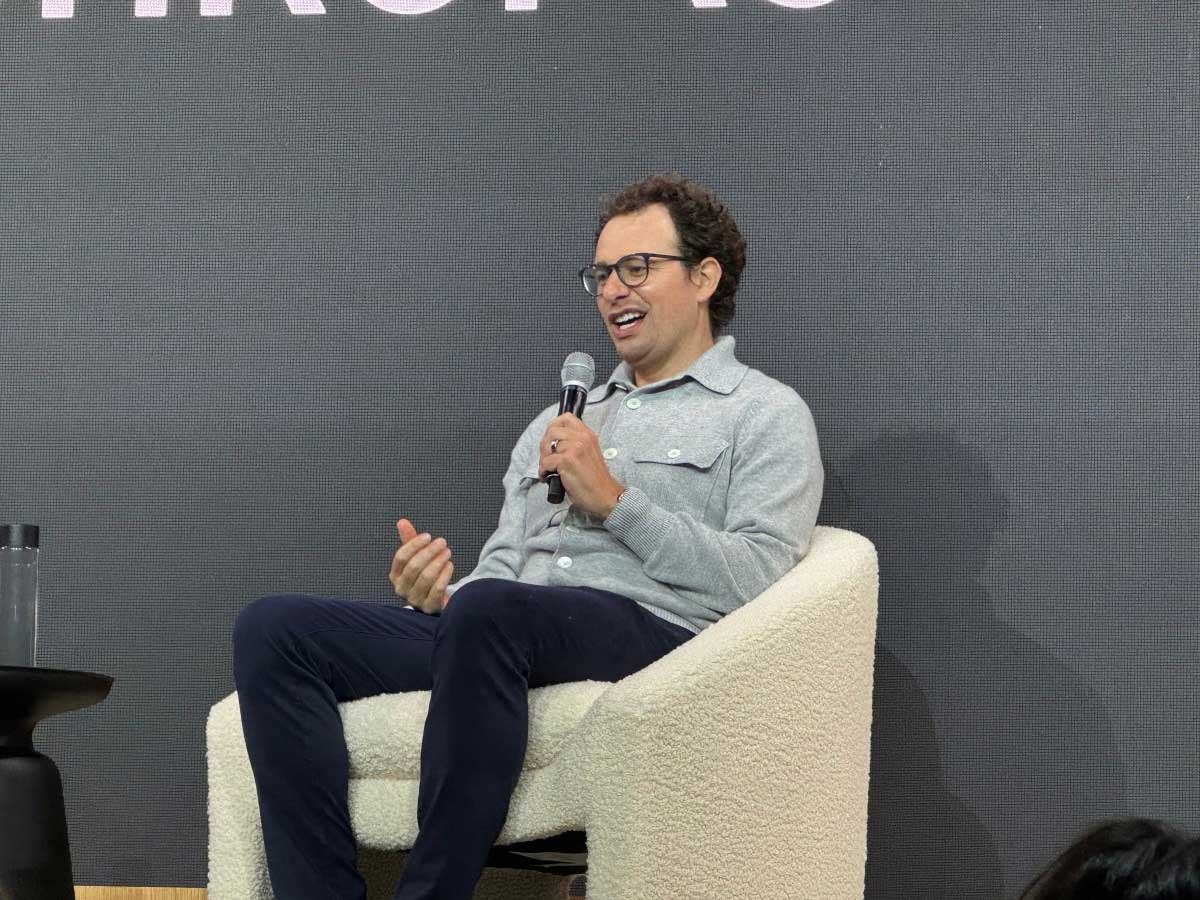

داریو آمودی، مدیرعامل Anthropic، معتقد است مدلهای هوش مصنوعی امروزی کمتر از انسانها دچار توهم میشوند یا اطلاعات نادرست را بهعنوان واقعیت ارائه میدهند. او این موضوع را در جریان یک نشست خبری در اولین رویداد توسعهدهندگان شرکت Anthropic با عنوان «کدنویسی با کلود» در سانفرانسیسکو مطرح کرد.

آمودی این صحبتها را در چارچوب نکتهای کلیتر مطرح کرد: اینکه توهمات هوش مصنوعی مانعی برای رسیدن Anthropic به AGI (هوش مصنوعی با سطح هوش انسانی یا بالاتر) محسوب نمیشوند.

او گفت: «واقعاً بستگی دارد که چطور آن را اندازهگیری کنیم، اما فکر میکنم مدلهای هوش مصنوعی احتمالاً کمتر از انسانها دچار توهم میشوند، ولی این توهمات به شکلهای شگفتانگیزتری رخ میدهند.» این پاسخ در واکنش به سؤال TechCrunch مطرح شد.

مدیرعامل Anthropic یکی از خوشبینترین چهرههای این صنعت نسبت به دستیابی مدلهای هوش مصنوعی به AGI است. در مقالهای که سال گذشته منتشر شد و بهطور گسترده مورد توجه قرار گرفت، آمودی گفته بود که AGI میتواند تا سال ۲۰۲۶ محقق شود. در نشست خبری روز پنجشنبه، او اعلام کرد که پیشرفت در این مسیر بهصورت پیوسته در حال انجام است و گفت: «آب در همهجا در حال بالا آمدن است.»

او افزود: «همه همیشه دنبال موانع سختی هستند که جلوی هوش مصنوعی را بگیرد، اما چنین چیزی وجود ندارد. مانعی در کار نیست.»

در مقابل، برخی دیگر از رهبران حوزه هوش مصنوعی معتقدند که توهمات، مانع بزرگی برای دستیابی به AGI محسوب میشوند. اوایل همین هفته، دمیس هسابیس، مدیرعامل Google DeepMind، اعلام کرد مدلهای هوش مصنوعی کنونی هنوز «حفرههای» زیادی دارند و در پاسخ به سؤالات بدیهی اشتباه میکنند. بهعنوان نمونه، اوایل این ماه، یک وکیل که نماینده Anthropic بود، مجبور به عذرخواهی در دادگاه شد چون از مدل Claude برای ساخت ارجاعها استفاده کرده بود و این چتبات اسامی و عناوین را بهاشتباه ذکر کرده بود.

تأیید ادعای آمودی دشوار است، چون بیشتر معیارهای ارزیابی توهم، مدلهای هوش مصنوعی را با یکدیگر مقایسه میکنند، نه با انسانها. با این حال، برخی روشها مانند فراهم کردن دسترسی مدلها به جستوجوی اینترنتی، به کاهش نرخ توهم کمک کردهاند. همچنین برخی مدلهای هوش مصنوعی، مانند GPT-4.5 از OpenAI، در مقایسه با نسلهای اولیه نرخ توهم کمتری در معیارها داشتهاند.

با این حال، شواهدی وجود دارد که نشان میدهد توهمات در مدلهای پیشرفتهتر هوش مصنوعی با توانایی استدلال در حال بدتر شدن هستند. مدلهای o3 و o4-mini از OpenAI نرخ توهم بالاتری نسبت به مدلهای استدلال نسل قبلی این شرکت دارند، و خود OpenAI هم دلیل آن را دقیقاً نمیداند.

در ادامه نشست خبری، آمودی اشاره کرد که مجریان تلویزیونی، سیاستمداران و انسانها در همه نوع حرفهها دائماً مرتکب اشتباه میشوند. به گفته او، اینکه هوش مصنوعی هم اشتباه میکند، دلیل بر عدم هوشمندی آن نیست. با این حال، مدیرعامل Anthropic اذعان کرد که نحوهای که مدلهای هوش مصنوعی با اطمینان بالا اطلاعات نادرست را بهعنوان حقیقت ارائه میدهند، میتواند مشکلساز باشد.

در واقع، شرکت Anthropic تحقیقات قابلتوجهی درباره گرایش مدلهای هوش مصنوعی به فریب انسانها انجام داده است، مشکلی که بهویژه در مدل جدید Claude Opus 4 دیده شده بود. مؤسسهای به نام Apollo Research که در زمینه ایمنی فعالیت میکند و دسترسی اولیه به این مدل داشت، اعلام کرد نسخه ابتدایی Claude Opus 4 تمایل زیادی به نقشه کشیدن علیه انسانها و فریب آنها داشت. این مؤسسه حتی پیشنهاد کرد که Anthropic نباید آن نسخه اولیه را منتشر میکرد. Anthropic گفت که اقداماتی برای کاهش این مشکلات انجام داده که بهنظر میرسد مؤثر واقع شدهاند.

اظهارات آمودی نشان میدهد که شرکت Anthropic ممکن است مدلی از هوش مصنوعی را حتی اگر هنوز دچار توهم شود، معادل AGI یا هوش انسانی در نظر بگیرد. با این حال، بسیاری از افراد بر این باورند که هوش مصنوعیای که دچار توهم میشود، از تعریف واقعی AGI فاصله دارد.آخرین اخبار دنیای تکنولوژی را از وب سایت تکنوتیس مشاهده کنید.